قانون دنماركي يمنح المواطنين حق ملكية أجسادهم لمحاربة التزييف العميق

,

قانون دنماركي يمنح المواطنين حق ملكية أجسادهم لمحاربة التزييف العميق

في زمنٍ باتت فيه الحقيقة محل شك، وتحولت فيه الوجوه إلى قوالب قابلة للتقليد، والأصوات إلى أدوات يمكن نسخها ببراعة مقلقة، تبرز قصة جديدة من قلب أوروبا، وتحديدًا من الدنمارك، تحمل في طياتها بذور الأمل والحماية الرقمية. تخيل أن تستيقظ ذات يوم لتجد مقطع فيديو يُظهر وجهك، يتحدث بصوتك، يقول أشياءً لم تقلها قط، وربما يرتكب أفعالًا لم تخطر لك على بال. كل شيء يبدو حقيقيًا، من نبرة الصوت إلى تعبيرات الوجه.

هذه ليست مشاهد من فيلم خيال علمي، بل واقع يُصاغ حاليًا بتقنيات “التزييف العميق” أو Deepfake، التي اجتازت حدود العبث وأصبحت أداة تهدد الخصوصية، والمصداقية، وأحيانًا السمعة والحياة نفسها. لكن وسط هذه الفوضى الرقمية، أطلقت الدنمارك شرارة تحرك غير مسبوق، قد يكون نقطة تحول في العلاقة بين الإنسان وبياناته الشخصية. أعلنت الحكومة الدنماركية عن مشروع قانون ثوري يمنح المواطنين حقوق ملكية قانونية على صورهم وأصواتهم وملامحهم. نعم، ملكية قانونية، كما تملك منزلك أو سيارتك، ستملك وجهك وصوتك رقميًا، وتقرر كيف ومتى ومن يستخدمهم.

أبرز الوظائف المُعرضة للاختفاء بسبب الذكاء الاصطناعي

هذا القانون لا يهدف فقط إلى تنظيم استخدام البيانات البيومترية، بل يسعى لحماية الإنسان في عصر لم يعد فيه من السهل التمييز بين الحقيقة والتزوير. خطوة جريئة تعيد تعريف الخصوصية الرقمية، وتمنح الأفراد قوةً كانوا قد بدأوا يفقدونها تدريجيًا مع تطور تقنيات الذكاء الاصطناعي. فهل تكون الدنمارك قد أطلقت أول حجر دومينو في سلسلة من القوانين العالمية المقبلة؟ وهل نشهد قريبًا عالمًا رقميًا أكثر عدالة؛ تحكمه القوانين لا الخوارزميات؟

ماهو التزييف العميق؟ التزييف العميق (Deepfake) هو تقنية متقدمة تعتمد على الذكاء الاصطناعي والتعلم العميق لإنشاء أو تعديل صور أو فيديوهات أو تسجيلات صوتية تبدو حقيقية لكنها في الواقع مزيفة بالكامل. المصطلح نفسه هو دمج لكلمتي “deep learning” أي التعلم العميق، و”fake” أي المزيف، ما يعكس جوهر التقنية التي تستخدم شبكات عصبية متقدمة لتوليد محتوى رقمي مزيف بدقة مذهلة.

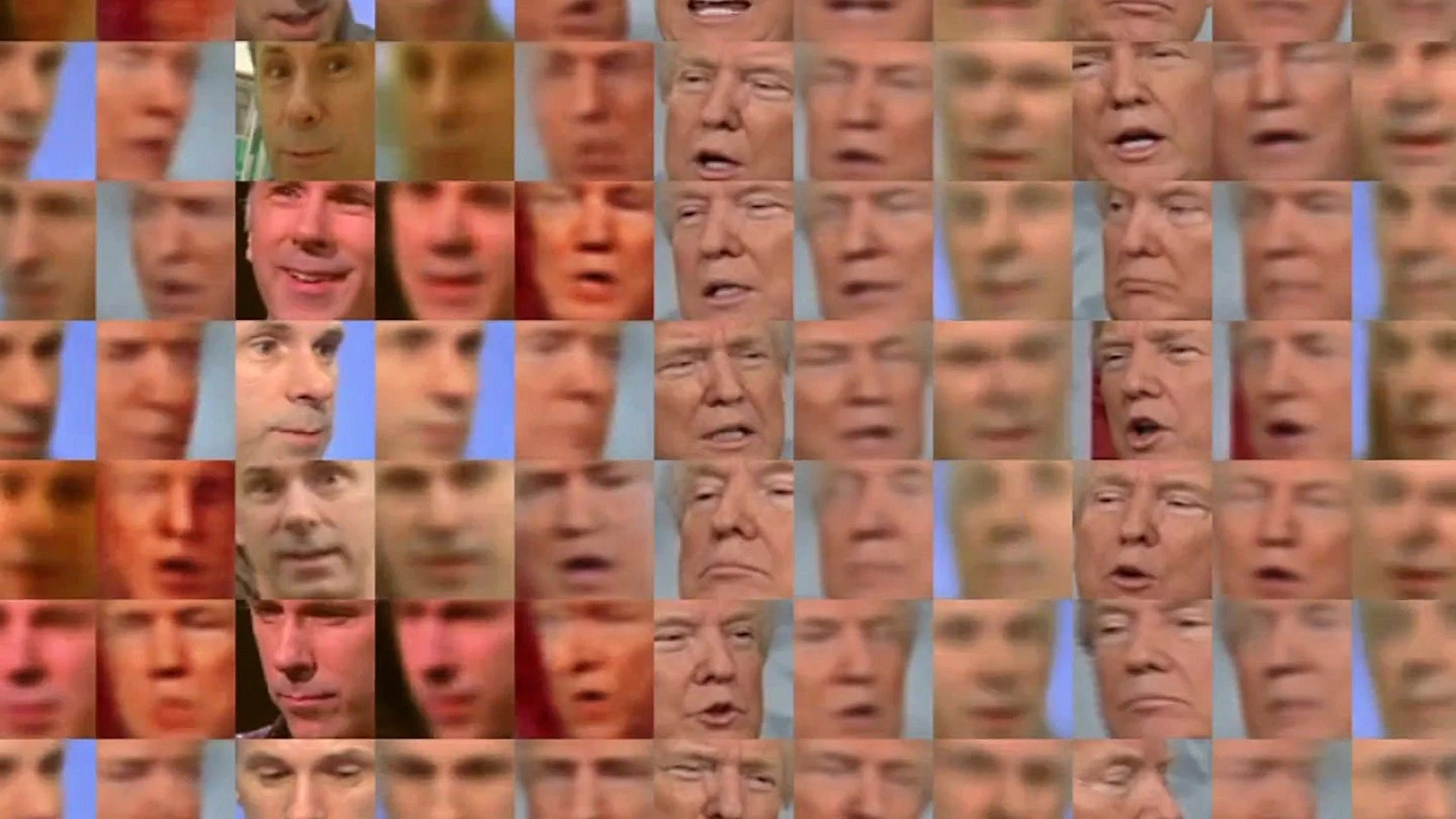

كيف يعمل التزييف العميق؟ تبدأ العملية بجمع كمية كبيرة من البيانات المتعلقة بالشخص المستهدف، مثل صور وفيديوهات وصوتيات متعددة الزوايا والتعبيرات. بعدها، يُدرب نموذج ذكاء اصطناعي، غالبًا باستخدام شبكات تنافسية مولدة (GANs)، حيث يتنافس نموذجان:

المولد (Generator) الذي يحاول إنشاء محتوى مزيف.

المميز (Discriminator) الذي يحاول كشف المزيف من الحقيقي.

هذا التنافس يحسن جودة المزيف تدريجيًا حتى يصبح شبه مستحيل التمييز بينه وبين المحتوى الحقيقي.

أشكال التزييف العميق

تبديل الوجه (Face Swap): استبدال وجه شخص بوجه آخر في فيديو أو صورة.

تزييف الصوت (Voice Synthesis): توليد صوت مزيف لشخص ليقول كلمات لم ينطق بها قط.

مزامنة الشفاه (Lip-sync): مطابقة حركة الشفاه في فيديو مع صوت مزيف.

هذه التقنيات تستخدم في خلق فيديوهات يظهر فيها أشخاص يفعلون أو يقولون أشياء لم تحدث أبدًا.

لماذا يصعب اكتشاف التزييف العميق؟ 1. تطور تقنيات التعلم العميق يعتمد التزييف العميق على شبكات عصبية متقدمة مثل المشفر التلقائي والشبكات التوليدية التنافسية (GANs)، حيث يتنافس نموذجان: مولد يحاول إنشاء صور أو فيديوهات مزيفة، ومميز يحاول كشف المزيف. هذا التنافس المستمر يؤدي إلى تحسين جودة المزيف بستمرار، بحيث تصبح الأخطاء أو العيوب التي يمكن اكتشافها نادرة جدًا وغير واضحة.

2. محاكاة دقيقة للضوء والظل وحركات الوجه أصبحت التقنيات الحديثة قادرة على معالجة الإضاءة والظلال بطريقة متقنة جدًا، مما يلغي العيوب التقليدية مثل الظلال غير الطبيعية أو الإضاءة غير المتناسقة التي كانت تساعد في كشف التزييف العميق سابقًا. كما أن حركات الشفاه تتزامن مع الكلام بدقة عالية، مما يصعب ملاحظة أي تباين بين الصوت والصورة.

3. استخدام كميات ضخمة من البيانات الحقيقية تُدرب نماذج التزييف العميق على كم هائل من الصور والفيديوهات الحقيقية المتاحة على الإنترنت، ما يسمح لها بالتعرف على أدق التفاصيل في ملامح الوجه والتعبيرات وحركات الجسم؛ وبالتالي إنتاج مزيفات تبدو طبيعية للغاية.

4. تطور مستمر يجعل الكشف هدفًا متحركًا يشبه التزييف العميق “هدفًا متحركًا”، فكلما طورت أدوات كشف المزيفات، تطورت أدوات التزييف نفسها لتتجاوز هذه الحواجز. هذا السباق المستمر يجعل من الصعب تطوير أدوات كشف فعالة بنسبة 100%.

5. صعوبة اكتشاف التناقضات الدقيقة بالعين المجردة حتى البشر المدربون يواجهون صعوبة في التمييز بين الفيديوهات الحقيقية والمزيفة، حيث تشير الدراسات إلى أن دقة الإنسان في اكتشاف التزييف العميق تتراوح بين 69% و72% فقط، وهذا يعني أن نسبة كبيرة من المزيفات تمر دون كشف.

6. الاعتماد على تفاصيل دقيقة يصعب ملاحظتها بعض العلامات التي يمكن البحث عنها مثل اختلاف ألوان الشفاه، الظلال غير الطبيعية، أو عدم تطابق حركة الشفاه مع الصوت، أصبحت أقل وضوحًا مع تطور التقنية، مما يقلل فرص اكتشاف التزييف بسهولة.

مخاطر وتهديدات التزييف العميق يحمل التزييف العميق (Deepfake) مخاطر وتهديدات جسيمة تطال الأفراد والمؤسسات والدول على حدٍ سواء، ويُعدّ تحديًا كبيرًا في عالم يشهد اعتمادًا متزايدًا على المحتوى الرقمي. إليكم عرضًا لأبرز هذه المخاطر:

1. التلاعب السياسي يُستخدم التزييف العميق لإنشاء فيديوهات مزيفة تظهر سياسيين يقولون أو يفعلون أشياء لم تحدث، خصوصًا في فترات الانتخابات؛ وهذا يؤثر على الرأي العام ويُضعف الثقة في العملية الديمقراطية. هذا يخلق ما يُعرف بـ”الدعاية الكاذبة” حيث يمكن للسياسيين الحقيقيين أن يُتهموا زورًا بأنهم يستخدمون التزييف لتبرير أخطائهم.

2. الإرهاب ونشر المعلومات المضللة تستخدم الجماعات الإرهابية التزييف العميق لصناعة فيديوهات مزيفة لهجمات أو تصريحات مزيفة لقادة عالميين، مما يثير الذعر ويُسهل تجنيد أعضاء جدد عبر رسائل مقنعة للغاية.

هل مازال العقل البشري قادرًا على هزيمة الذكاء الاصطناعي في الحرب؟

3. الاحتيال المالي وانتحال الهوية تُستخدم تقنيات التزييف العميق في عمليات احتيال معقدة، مثل تقليد صوت المدير التنفيذي لإصدار أوامر تحويل أموال ضخمة، كما حدث في 2019 حين تم خداع مدير شركة بتحويل 243,000 يورو بناءً على أوامر صوتية مزيفة.

4. الابتزاز والاعتداء على الخصوصية تنتشر فيديوهات التزييف العميق الإباحية غير المرخصة التي تستهدف خصوصية الأفراد، خصوصًا النساء، ما يؤدي إلى أضرار نفسية…..

لقراءة المقال بالكامل، يرجى الضغط على زر “إقرأ على الموقع الرسمي” أدناه

المزيد من عرب هاردوير

الأكثر تداولا في تكنولوجيا

الكويت

الكويت السعودية

السعودية مصر

مصر الإمارات

الإمارات لبنان

لبنان البحرين

البحرين الأردن

الأردن فلسطين

فلسطين اليمن

اليمن المغرب

المغرب ليبيا

ليبيا تونس

تونس عمان

عمان العراق

العراق الجزائر

الجزائر